こんにちは、株式会社ACESの開発部責任者の久保 (@seishin55) です。

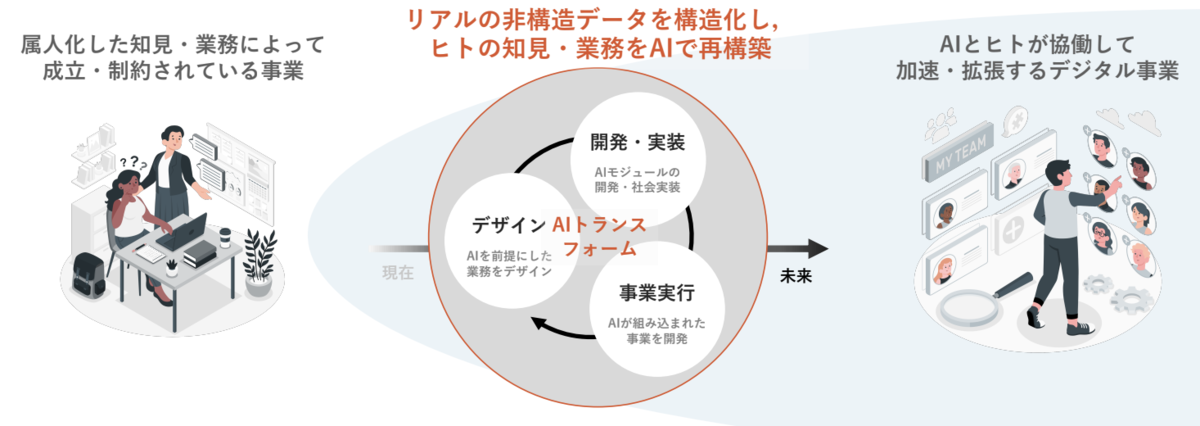

ACESは自然言語や音声、映像といった非構造データを構造化し、属人化した知見や業務をDeep Learningを中心としたAI技術で再構築しながら、人とAIが協働し、ともに進化できる未来をデザインすることに取り組んでいます。

今回は特に力を入れて取り組んでいる「コミュニケーションの科学」について紹介します。

コミュニケーションの科学

コミュニケーションの科学とは?

昨今の時勢の影響も受けながら、私達の生活様式は大きく変わり、オンライン上でのコミュニケーションも当たり前になりました。ZoomやTeams、Google Meetのような動画を介したやり取りが普及し、VRのようなバーチャル空間上でのやり取りも行われるようになりました。これまでのコミュニケーションのあり方が多様になっていること、また、デジタルを介したコミュニケーションが増え、解析・介入する余地が増えたことによって、改めてコミュニケーションのあり方を考える好機が生まれています。

コミュニケーションが発生する場面・業界は多岐に渡りますが、例えば、営業、会議、コールセンター、問診、カウンセリング、コーチング、人事などが想定されます。ACESでは、まずはコミュニケーションの解析・データ化に注力し、以下の項目に取り組んでいます。

これらは、これまで属人化されていた個人のスキルを解析し、「質の高いコミュニケーションは何か?」という問いにチャレンジするものです。

また、解析の延長として、人と人のコミュニケーションにAIを介在させることも行います。例えば、以下のように、よそ見を検知したAIが人の注目を集めるアクション(ここでは話す速度をあげる)を取ることで、人の行動を変容させます。

[CHI '21 Arakawa and Yakura] Mindless Attractor: A False-Positive Resistant Intervention for Drawing Attention Using Auditory Perturbation (Honorable Mention 受賞)

これに限らず、質問対応業務の中で、「自動的に回答候補を出し、人の補助を行う」など、人のコミュニケーションに介入・補助できるようにして、コミュニケーションを直接的にアップデートしていきます。

そして、将来的には、音声合成やアバターの活用などのデジタルインターフェースも介して人とAIのコミュニケーションにもチャレンジします。

コミュニケーションの科学の方位磁針「トラスト」

人とAIが協働していく未来を実現するためには、人とAIの間のトラスト(信頼関係)が大切だと考えています。AIをプロダクトやサービスに組み込む場合に、そのAIに信頼を持って使ってもらえるかを重視し、議論を行っています。例えば、AIによる書き起こしの結果にミスがあった場合のために、対応する時間の動画を参照し、情報を補完できるように工夫を行います。技術的に素晴らしいものがあったとしても、人がその使い方を理解できなかったり、非直感的な間違いが多く認知負荷が高い場合は、うまく使うことができず、効用が小さくなってしまいます。

また、人とAIが協働する中で、① データが蓄積され、AIが強くなること、② より質の高いAIのサポートを受けることで人も強くなること、③ 質の高いデータがAIにFBされること、のループを回すことによって、人とAIが共に進化することを目指します。このような、人間がシステムのループの中で相互作用を生み出すことは Human in the loopと呼ばれており、人とAIの不得意をそれぞれが補う形で協働することをイメージしています。

営業を科学する「ACES Meet」

ACESでは、コミュニケーションの科学の取り組みの1つの役割・インターフェースとして、ACES Meetというプロダクトを開発しています。ACES Meetは、AIがオンライン商談の録画・書き起こしを行い、商談の内容や温度感を共有・解析できる営業支援AIツールです。

ACES Meetは以下の画像のように、オンライン商談を分析します。動画から書き起こし、会議のトピックの分析 (何を話しているのか) 、重要なシーンの抽出、コミュニケーションスキルの定量化 (例: 話速)などの解析を現在は行っています。

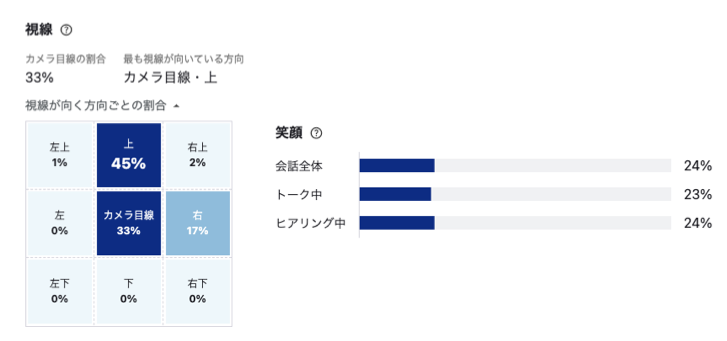

また、これに限らず様々な技術トピックで研究・開発が行われており、最近、その一部である笑顔・視線の分析のリリースが出されましたし、要約技術について特許の出願も行っているところです。

現在の取り組みテーマ

対話要約・Q&A (自然言語)

コミュニケーションは言語を介して行われるため、自然言語による解析は重要です。現在はまず、商談/会議における議事まとめ業務をAIでサポートするための研究・開発を行っています。前述したように、既に特許出願を行っている要約技術もありますが、一言で要約といっても様々な形があります。商談/会議の実施者が議事にまとめる作業において、どのようなステップがあり、どのようなAIが重要かを考えながら、研究・開発を行っています。

ニュースのような整ったテキストではなく、口語表現が混じった対話のやり取りであったり、会話データのために重要な情報がスパースになっていたりと対話文章であることの特有な難しさがあり、チャレンジングな領域になっています。また、生成される文章は単にそれっぽい文章であればよいわけではありません。例えば、要約の中で誰の発言かを間違ってしまうことは大きなミスで、ユーザーの信頼を失ってしまいます。そうならないために、適切なアプローチ・ステップを考える必要があります。

また、対話文章ではQ&A(質問と答え)は重要な要素です。例えば、Q&Aを対話文章から抽出する要素技術がありますが、Q&Aの抽出は上記の要約にも寄与しますし、Q&Aの集積はノウハウ蓄積にも繋がります。また、蓄積されたQ&Aのペアのデータを元にAIが介入することで、新規のメンバーであっても既存のQ&A (例えば、答えの候補)をリアルタイムで確認できることに使うこともできます。

近年では、特に自然言語はTransformer及びBERT、GPT-3などの発展、特に大規模モデル化の恩恵を受けて、実現可能な範囲・水準が上がっています。そうした最先端の研究領域の知見の恩恵も受けながら、まずは「解析」を行いつつ、開発内容を拡張していきます。

書き起こし (音声認識)

発話を伴うコミュニケーションを解析するためには音声認識を行い、書き起こしを行う必要があります。書き起こしの機能はプロダクトとして運用しているACES Meetに搭載・運用されているため、その中でユーザーからのフィードバックも受けながら書き起こしのモデルの開発・改善を繰り返し、精度を向上させています。また、データの蓄積とアノテーションの仕組み化も行っており、継続的に学習できる仕組みが整っています。

音声認識は最近ではOpenAIから公開された大規模言語モデルのWhisperが注目されるなど、音声認識の分野にも大規模モデル化の波が来ています。現状ACESで開発・運用されている音声認識モデルは独自の学習データで学習していることから、対象とするオンライン会議ドメインにおいて、定量的・定性的にWhisperの精度を上回っていますが、大規模モデルの影響は大きいと考え、その恩恵を取り入れるための開発も行っています。また、固有名詞や専門用語の書き起こしを可能にし、精度の向上を行うための取り組みも短期・長期それぞれの施策に取り組んでいます。

今後としては、同一音源の複数人の話者分割やリアルタイムの音声認識の開発なども含めて、開発が検討されています。

分析指標・重要シーン抽出 (マルチモーダル)

コミュニケーションの解析にあたって、スキルを分析指標として、定量化・可視化することにも取り組んでいます。個人のスキルを定量的に把握・認識し、また、他者との比較によって、自分の得意・不得意を認識できるようになることによって、これまではブラックボックスで難しかったコミュニケーションスキルの改善に生かすことが可能になります。分析指標としては、非言語 (映像解析)、準言語 (話す際の声の強弱などの語調など)、言語 (発話内容)に分けて開発を行っています。前述したように、自然言語処理や音声認識の開発を注力していることと、別領域の開発によって映像解析も弊社の得意な技術領域であることから様々な指標が開発されています。指標の例を挙げると、弊社プロダクトであるACES Meetでは既に以下のように笑顔の指標と視線の指標が表示されます。

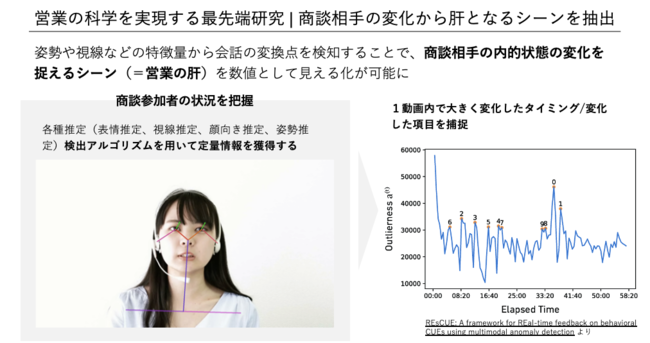

現在ACES Meetに搭載されているアルゴリズムは内部で開発されているもののうち一部のみで、今後も内容の拡充が行われる予定です。内部的には他社との取り組みを含めて、様々な研究・開発が行われているところです。例えば、人材アセスメント支援業務におけるプロジェクトとして以下のような研究を行い、CHI 2022のワークショップである Trust and Reliance in Human-AI Teaming に採択されています。

また、取得される各種定量情報の時系列的な情報から特徴的なシーン (大きく変化したタイミング)を推定する技術も保有しています(弊社特許技術)。以下の例は映像データの例ですが、同技術では音声・自然言語も含めた様々なモーダルから得られる指標を使って推定を行うことが可能で、活用が進んでいます。

さらに、現在は上記のマルチモーダルな指標を使って観察したいシーンを汎用的に取得できる技術の研究・開発を行っているところです。どの指標が改善対象として重要であるかの分析も重要で合わせて進めています。

おわりに

今回はACESが現在特に力を入れている「コミュニケーションの科学」の取り組みについて紹介しました。現在は対面の商談/会議等を解析し、効率化や定量化・評価による振り返り、ノウハウ蓄積を行ってますが、冒頭でも触れたように、今後としては、リアルタイムにフィードバックを返したり、トーク内容をサポートしたりするように人のコミュニケーションに介入・補助して、支援できる領域を拡張したり、音声合成やアバター、対話のようなデジタルインターフェースの活用によって、AIが人と直接的に協働できるような展開にもチャンレンジしていくことを想定しています。

それを実現するために、現在、特に自然言語処理のアルゴリズムエンジニアを募集しています。弊社の取り組みに興味を持って頂ける場合は是非ご応募頂けますと幸いです。

Talentio (Tech Lead / 自然言語処理): open.talentio.com

Talentio (Algorithm Engineer / 自然言語処理): open.talentio.com

Meety: meety.net

よく分からなければ私へTwitter DMでも大丈夫です!@seishin55

まずは30分のカジュアル面談からでもできればと思うので、お気軽にご応募・お声掛け下さい!